Tempo di lettura: 11’. Leggibilità ***.

È già Apocalypse now?

Elon Musk ha detto che l’intelligenza artificiale può scatenare la terza guerra mondiale. Se a dirlo è il costruttore dell’auto con intelligenza artificiale più avanzata e mercuriale del pianeta, vuol dire che un fondamento c’è. Fino a poco tempo fa erano pochissimi a preoccuparsi delle conseguenze dell’innovazione tecnologica che stava prendendo un passo furioso. Ed eravamo appena agli inizi, non si era visto ancora niente.

Poi è successo che il discorso sulle conseguenze della tecnologia ha iniziato a percolare in ogni ambiente della società, eccetto che tra i tecnologi che sono convinti di essere “in missione per conto di Dio”. L’imputato principale di questo rovesciamento di percezione pubblica è proprio l’intelligenza artificiale.

Quando si parla di intelligenza artificiale, una gran parte della conversazione pubblica tende a concentrarsi non solo sulla perdita dei posti di lavoro o sul vantaggio della Cina. Ma anche e soprattutto sulla paura che le macchine intelligenti un giorno conquisteranno il mondo rendendo l’uomo un mero anello della catena alimentare. Non è quello che avviene nella Guerra dei mondi di Huxley?

L’assunto implicito è che uomini e macchine siano in competizione. Una competizione che sarà vinta dalla macchina. Alla fine i sistemi intelligenti, con la loro velocità, la capacità di processare e la resistenza all’usura, ci sostituiranno prima nelle professioni, poi nelle organizzazioni e infine nelle decisioni.

C’è uno studio econometrico del 2015 del National Bureau of Economic Research, un centro di ricerca che prevede con sufficiente accuratezza i trend economici, che ha tratto questa conclusione:

In assenza di un’adeguata politica fiscale che ridistribuisca dai vincenti ai perdenti, le macchine intelligenti significheranno nel lungo termine più povertà per tutti.

Due condizioni che al momento sembrano ben lungi dal venire, se non addirittura dall’essere concepite. Una cosa però sta avvenendo: una parte importante della popolazione nei paesi sviluppati si sta, in effetti, impoverendo. E sappiamo che l’impoverimento può avere conseguenze anche più brutali dell’intelligenza artificiale.

L’intelligenza additiva

Satya Nadella, CEO di Microsoft, ha commentato con queste parole il senso del libro: «Daugherty e Wilson alzano la barra della conversazione che tutti dovremmo avere sul futuro della collaborazione fra uomo e computer grazie a strumenti concreti come l’ipotesi dello “spazio fantasma” e principi organizzativi fondati sulla ricerca. Con abilità pragmatica ed entusiasmo, gli autori hanno prodotto una mappa che ci guida verso un futuro più produttivo.»

Cerchiamo di vedere la faccenda da una prospettiva diversa. Chiediamoci. E se l’operazione di potenza uomo-macchina non fosse sottrattiva, ma additiva? È questa la prospettiva proposta da Paul Daugherty e James Wilson in un libro finalmente tradotto in italiano Human + machine. Ripensare il lavoro nell’età dell’intelligenza artificiale, Guerini, 2019, pp. 215 (disponibile anche in ebook in coedizione con goWare).

Il lavoro non è teorico o affabulatorio, ma trae le sue considerazioni dall’esperienza sul campo acquisita dai due autori. Entrambi, infatti, ricoprono responsabilità primarie in Accenture. Daugherty è Chief Technology e Innovation Officer e si occupa dei progetti sull’Intelligenza artificiale e sulla R&D a livello globale. Wilson è a capo del dipartimento di IT e Business Research.

Accenture è la più grande società di consulenza aziendale al mondo. Respira la stessa aria delle imprese, soprattutto grandi, per le quali lavora spalla a spalla. Difficile disporre di un osservatorio con una vista migliore sul territorio dove si attuano l’innovazione e i cambiamenti.

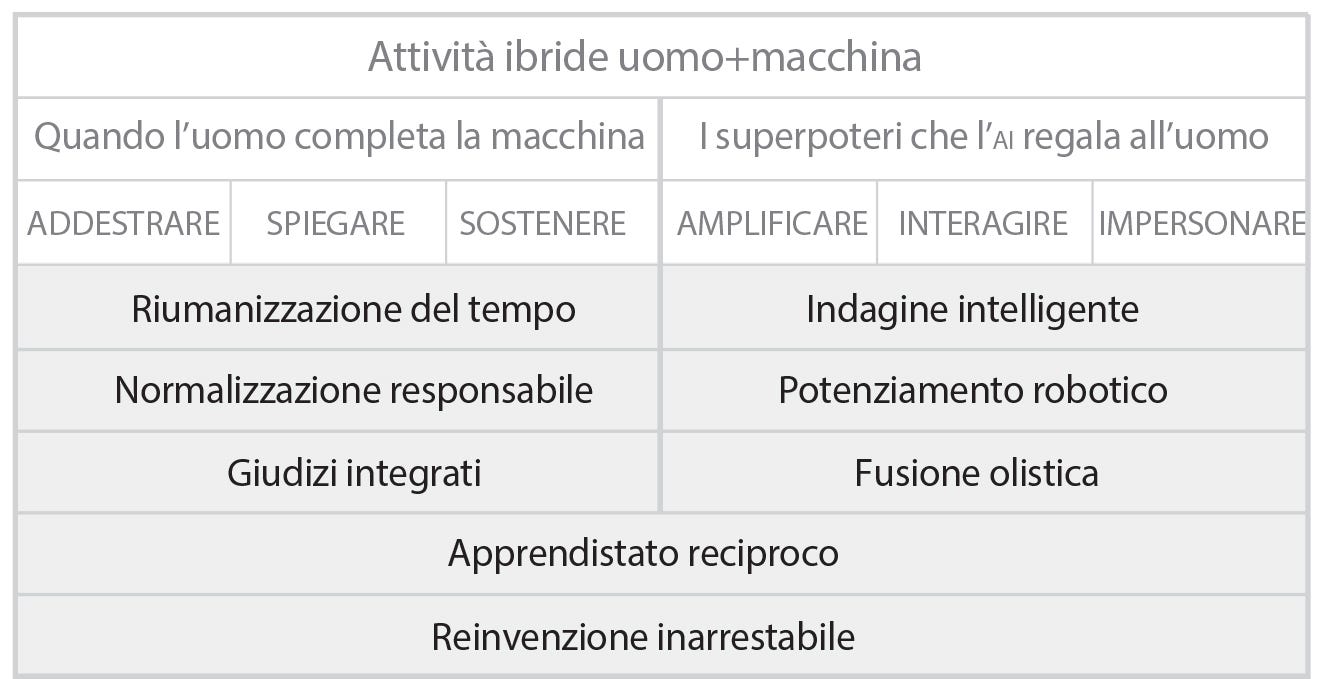

Daugherty e Wilson hanno condotto un’analisi su 450 organizzazioni all’interno di un campione di 1500 e hanno identificato un certo numero di fenomeni rilevanti che le ricerche quantitative hanno mancato di cogliere. Uno è il concetto di «fusion skill»: uomini e macchine insieme formano nuovi tipi di lavoro ed esperienze professionali.

Proprio questa fusione di saperi e competenze è lo “spazio fantasma”. Fantasma nel senso che è assente dal dibattito polarizzante sul lavoro che ha messo in contrapposizione uomini e macchine. Ed è in questo spazio fantasma centrale che le aziende all’avanguardia hanno reinventato i processi lavorativi, ottenendo straordinari miglioramenti nelle performance.

Il re-skilling

Nella prefazione al libro, Paolo Traverso, direttore del Centro FBK ICT Fondazione Bruno Kessler, sintetizza benissimo la tesi dei due autori.

Il senso dell’opera si preannuncia nel titolo: il futuro non è nelle macchine di per sé, intelligenti che siano, non è nella pura automazione industriale, se pur spinta al massimo fino a rimpiazzare un’alta percentuale delle componenti più routinarie e a bassa creatività di ciascun mestiere.

Il futuro della società, ma anche del mercato e del business, è in realtà laddove le macchine e le persone lavorano assieme, dove i mestieri ma anche i modelli di business si rinnoveranno in un modo sostanziale.

L’intelligenza artificiale non deve rimpiazzare le persone, le loro capacità, la loro creatività, ma le deve esaltare, le deve aumentare.

La leva fondamentale perché questo avvenga sta in quello che gli autori chiamano il re-skilling, cioè nel preparare milioni di persone di tutte le età a lavorare con le nuove tecnologie. Un’impresa titanica, ma imprescindibile.

Anche una tecnologa pentita come Arianna Huffington, che adesso propugna la disconnessione, ha apprezzato molto il lavoro dei due autori che alla fine va nella direzione di un assorbimento della tecnologia entro la condizione umana fino a farne parte integrante. Ecco come si esprime a proposito del libro:

In Human + Machine, Daugherty e Wilson forniscono un modello di futuro in cui l’intelligenza artificiale potenzia il nostro lato umano.

Pieno di esempi, istruzioni e ispirazione, il libro è una guida pratica alla comprensione dell’intelligenza artificiale — a ciò che significa per le nostre vite e a come possiamo sfruttarla al meglio.

Una breve storia dell’intelligenza artificiale

1956

La tecnologia trainante dietro l’attuale epoca di processi adattativi è l’intelligenza artificiale, evolutasi negli ultimi vent’anni. La sua storia in breve ci fornirà un contesto in cui inquadrare caratteristiche e potenzialità più avanzate.

Il settore dell’intelligenza artificiale nasce ufficialmente nel 1956, quando un piccolo gruppo di scienziati e ricercatori informatici diretto da John McCarthy, e che includeva Claude Shannon, Marvin Minsky e altri ancora, si riunisce al Dartmouth College per la prima conferenza dedicata alla possibilità che l’intelligenza delle macchine possa imitare l’intelligenza umana.

La conferenza, sostanzialmente una sessione prolungata di brainstorming, si basava sull’assunto che ogni aspetto di apprendimento e creatività potesse essere descritto in maniera così precisa da poter diventare un modello matematico, dunque replicato dalle macchine. Gli obiettivi erano ambiziosi, a partire dalla proposta progettuale: «Verrà messo in atto qualunque tentativo per scoprire come rendere una macchina in grado di usare linguaggio, forma, astrazioni e concetti, risolvere tipologie di problemi attualmente limitate agli esseri umani, e migliorarsi». Ovviamente, non era che l’inizio.

La conferenza riuscì immediatamente a circoscrivere il campo e a unificare molte delle idee matematiche che volteggiavano attorno al concetto di intelligenza artificiale.

I pionieri

E nei decenni che seguirono, ispirò aree di ricerca totalmente nuove. Per esempio Minsky, assieme a Seymour Papert, scrisse quello che viene considerato il libro fondativo su limiti e possibilità delle reti neurali, un tipo di intelligenza artificiale che usa come modello i neuroni biologici. Altre idee come i sistemi esperti — in cui un computer viene dotato di riserve profonde di «conoscenza» relativa ad ambiti specifici come architettura o diagnostica medica — o l’elaborazione del linguaggio naturale, la visione artificiale e la robotica portatile, possono ugualmente essere ricondotte a questo evento.

Fra i partecipanti alla conferenza c’era Arthur Samuel, un ingegnere dell’ibm che stava costruendo un programma informatico per giocare a dama. Il suo programma valutava lo stato di una scacchiera e calcolava le possibilità che una data posizione potesse portare alla vittoria.

Nel 1959, Samuel coniò l’espressione machine-learning, «apprendimento automatico»: ovvero, quel settore di ricerca che attribuisce ai computer la capacità di imparare senza essere esplicitamente programmato. Nel 1961 il suo programma di machine-learning fu usato per sconfiggere il quarto giocatore di dama degli Stati Uniti.

Ma poiché Samuel era una persona riservata e non praticava la politica dell’autopromozione, bisognò attendere il suo pensionamento dall’ibm nel 1966 perché l’importanza del suo lavoro sul machine-learning diventasse di pubblico dominio.

Il machine learning

Nei decenni che seguirono la conferenza, il machine-learning rimase qualcosa di oscuro, mentre l’attenzione era rivolta ad altri modelli di ai. In particolare, le ricerche condotte negli anni Settanta e Ottanta si concentravano su un concetto di intelligenza basato su simboli fisici e manipolato da regole logiche. Questi sistemi simbolici, tuttavia, non trovarono successo nella pratica, e il loro fallimento portò a un periodo conosciuto come «l’inverno dell’intelligenza artificiale».

Nel 1990 però il machine-learning cominciò a rifiorire e i suoi sostenitori adottarono nel loro approccio statistica integrata e teoria delle probabilità. Nello stesso periodo cominciava la rivoluzione del personal computer. Nel decennio successivo sistemi digitali, sensori, internet e i telefoni cellulari sarebbero diventati comuni, fornendo qualunque tipo di dato agli esperti di machine-learning che mettevano a punto i loro sistemi adattativi.

Oggi pensiamo a un programma di machine-learning come a un costruttore di modelli basati su set di dati che ingegneri e specialisti utilizzano per addestrare il sistema. È un contrasto netto con la programmazione informatica tradizionale. Gli algoritmi standard seguivano sentieri predeterminati messi in moto da istruzioni statiche o dai codici dei programmatori. Un sistema di machine-learning, per contro, può imparare in corso d’opera. Con ogni nuovo set di dati, aggiorna i suoi modelli e il modo in cui «vede» il mondo. In un’epoca in cui le macchine possono imparare e cambiare grazie a esperienze e informazioni, i programmatori sono diventati sempre meno legislatori e dittatori, e molto più simili a insegnanti e allenatori.

Oggi come oggi

Oggi i sistemi di intelligenza artificiale che impiegano il machine-learning sono ovunque. Le banche li usano per proteggersi dalle frodi; i siti di incontri li usano per suggerire match potenziali; esperti di marketing li usano per prevedere chi risponderà favorevolmente a una pubblicità; e i siti di condivisione di foto li usano per il riconoscimento automatico dei volti. Molta strada è stata fatta dalla prima partita a dama. Nel 2016, Google AlphaGo ha segnato un significativo progresso nel settore. Per la prima volta, un computer ha battuto un campione di Go, un gioco assai più complesso di dama o scacchi. Come segno dei tempi, AlphaGo ha prodotto mosse talmente inaspettate che alcuni osservatori le hanno definite creative, addirittura «belle».

La crescita dell’intelligenza artificiale e del machine-learning è stata intermittente nel corso degli anni, ma il modo in cui entrambi hanno recentemente fatto irruzione nei prodotti e nelle business operations dimostra che sono più che pronti per un ruolo da protagonisti. Secondo Danny Lange, ex responsabile del machine-learning di Uber, la tecnologia ha finalmente lasciato le mura dei laboratori di ricerca e sta rapidamente diventando «la pietra angolare di questa nuova, burrascosa trasformazione industriale».

Tecnologie intelligenti e applicazioni: come possono coesistere?

Ecco un glossario della costellazione di tecnologie di cui oggi è necessario essere a conoscenza. Queste tecnologie corrispondono al machine-learning, capacità dell’intelligenza artificiale e livelli di applicazioni come da figura sotto.

Componenti del machine-learning

— Machine-learning (ML). Il campo della scienza informatica che tratta gli algoritmi che imparano dai dati e dai dati fanno previsioni senza bisogno di essere esplicitamente programmati. È un settore che ha le sue radici nella ricerca di Arthur Samuel della ibm, che nel 1959 coniò il termine e utilizzò i principi del machine-learning nel suo lavoro sui computer games. Grazie all’esplosione di dati disponibili per addestrare gli algoritmi, il machine-learning è attualmente usato in campi tanto diversi quanto tentacolari come la ricerca sulla computer vision, l’indagine sulle frodi, la previsione dei prezzi, l’elaborazione del linguaggio naturale e altro ancora.

— Apprendimento sorvegliato. Un tipo di machine-learning nel quale si presentano a un algoritmo dati pre-classificati e selezionati (in gergo tecnico labeled data, dati marcati) composti di input esemplari e output desiderati. Lo scopo dell’algoritmo è imparare le regole generali che connettono gli input agli output e usare tali regole per predire eventi futuri a partire dai soli dati di input.

— Apprendimento non sorvegliato. All’algoritmo non si forniscono label, lasciando che sia lui da solo a trovare strutture e modelli di input. L’apprendimento non sorvegliato può essere fine a se stesso (quanto alla scoperta dei modelli nascosti nei dati) o mirare a qualcosa di preciso (ad esempio, estrarre tratti pertinenti dai dati). L’apprendimento non sorvegliato è meno concentrato sull’output rispetto all’apprendimento sorvegliato, e più mirato all’esplorazione dei dati di input e all’inferenza di strutture nascoste e dati non marcati.

— Apprendimento semi-sorvegliato. Usa dati marcati e non marcati — generalmente più i secondi. Molti ricercatori hanno trovato che la combinazione dei due set di dati aumenta in modo considerevole l’accuratezza del processo di apprendimento.

— Apprendimento per rinforzo. Si tratta di un tipo di addestramento in cui a un algoritmo si assegna una meta specifica, per esempio manovrare un braccio meccanico o giocare a Go. Ogni mossa che l’algoritmo compie è premiata o punita. Il feedback permette all’algoritmo di costruire il percorso più efficiente verso la meta.

— Rete neurale. Un tipo di machine-learning in cui un algoritmo, imparando da dati osservazionali, processa informazioni in un modo simile al sistema nervoso umano. Nel 1957 Frank Rosenblatt, della Cornell University, ha inventato la prima rete neurale, un’architettura semplice, a un solo livello (conosciuta come rete superficiale).

— Apprendimento profondo e sottoinsiemi: reti neurali profonde (DNN, deep neural networks), reti neurali ricorrenti (rnn, recurrent neural networks) e reti neurali anticipatrici (FNN, feedforward neural networks). Set di tecniche per addestrare una rete neurale multilivello. Nel dnn i dati «percepiti» vengono processati attraverso diversi livelli; ogni livello usa gli output del precedente come input. La rnn permette ai dati di andare avanti e indietro fra i livelli, diversamente dalle fnn, in cui i dati sono monodirezionali.

Componenti delle abilità intelligenti

— Sistema predittivo. Sistema che trova relazioni fra variabili in set di dati storici con relativi esiti. Le relazioni vengono utilizzate per sviluppare modelli, che a loro volta servono per predire scenari futuri.

— Ricerca locale (ottimizzazione). Un approccio matematico al problem solving che fa uso di un’ampia serie di soluzioni possibili. L’algoritmo cerca la soluzione ottimale cominciando da un punto della serie e muovendosi iterativamente e sistematicamente alle soluzioni vicine finché non trova quella ottimale.

— Rappresentazione della conoscenza. Un campo dell’intelligenza artificiale dedicato alla rappresentazione delle informazioni sul mondo in una forma che il computer può utilizzare per eseguire compiti, come eseguire una diagnosi medica o intrattenere una conversazione con una persona.

— Sistemi esperti (inferenza). Un sistema che utilizza una conoscenza settoriale (medicina, chimica, giurisprudenza) combinata con un motore basato su regole che decide in che modo quella conoscenza va applicata. Il sistema migliora man mano che nuove informazioni vengono aggiunte o quando le regole vengono aggiornate o aumentate.

— Computer vision. Un ambito dedicato a insegnare ai computer a identificare, categorizzare e comprendere il contenuto di immagini e video, imitando e implementando la visione umana.

— Elaborazione di segnali audio. Machine-learning utilizzabile per analizzare segnali audio e altri segnali digitali, specialmente in ambienti ad elevata saturazione sonora. Le applicazioni includono discorso computazionale ed elaborazione audio e audiovisiva.

— Speech to text. Reti neurali che convertono segnali audio in segnali di testo in una varietà di lingue naturali. Le applicazioni comprendono traduzione, comando e controllo vocale, trascrizione audio e altro.

— Elaborazione del linguaggio naturale (NLP, natural language processing). Un ambito nel quale i computer elaborano le lingue umane (naturali). Le applicazioni includono riconoscimento vocale, traduzione automatica, analisi dei sentimenti.

Componenti delle applicazioni di AI

— Agenti intelligenti. Agenti che interagiscono con persone attraverso il linguaggio naturale. Possono essere utilizzati per implementare mano d’opera umana nel customer service, nelle risorse umane, nei tirocini e in altre aree aziendali dove si gestiscono richieste modello faq.

— Robotica collaborativa (cobots). Robot che operano a velocità minori e sono equipaggiati con sensori che permettono un’interazione sicura con colleghi umani.

— Riconoscimento biometrico, facciale e gestuale. Identifica persone, gesti o tendenze nelle misurazioni biometriche (stress, attività ecc.) per scopi legati all’interazione uomo-macchina, o di identificazione e verifica.

— Automazione intelligente. Trasferisce alcuni compiti dall’uomo alla macchina per cambiare in maniera drastica l’operatività tradizionale. Attraverso potenzialità e abilità proprie delle macchine (velocità, ampiezza, capacità di aggirare la complessità), questi strumenti fanno da complemento al lavoro umano e lo espandono dove possibile.

— Sistemi di raccomandazione. Forniscono suggerimenti basati su modelli sottili individuati nel corso del tempo dagli algoritmi. Possono essere indirizzati verso clienti per suggerire nuovi prodotti o usati internamente per suggerimenti strategici.

— Prodotti intelligenti. L’intelligenza è integrata nel design in modo tale che possano evolvere costantemente per incontrare e anticipare i bisogni e le preferenze dei clienti.

— Personalizzazione. Analizza i trend e i modelli per clienti e dipendenti in modo da ottimizzare strumenti e prodotti per utenti individuali o clienti.

— Riconoscimento di testo, discorso, immagine e video. Interpreta i dati da testi, discorsi, immagini e video e crea associazioni che possono essere usate per ampliare attività analitiche e rende possibili applicazioni avanzate per interazione e visione.

— Realtà aumentata. Combina la potenza dell’ai con le tecnologie di realtà virtuale, aumentata e mista per aggiungere intelligenza a formazione professionale, manutenzione e altre attività